- Регистрация

- 12.04.17

- Сообщения

- 19.095

- Реакции

- 107

- Репутация

- 0

Новые архитектуры нейросетей

Предыдущая статья «

В этой статье кратко рассматриваются некоторые архитектуры нейросетей, в основном по задаче обнаружения объектов, чтобы найти (или хотя бы попытаться найти) будущие направления в этой быстро развивающейся области.

Статья не претендует на полноту охвата и хорошее понимание прочитанных «по диагонали» статей. Автор уверен, что пока писал эту статью, появилось еще много новых архитектур. Например, смотрите здесь:

Интересное видео с рекомендациями, как спроектировать нейронную сеть: «

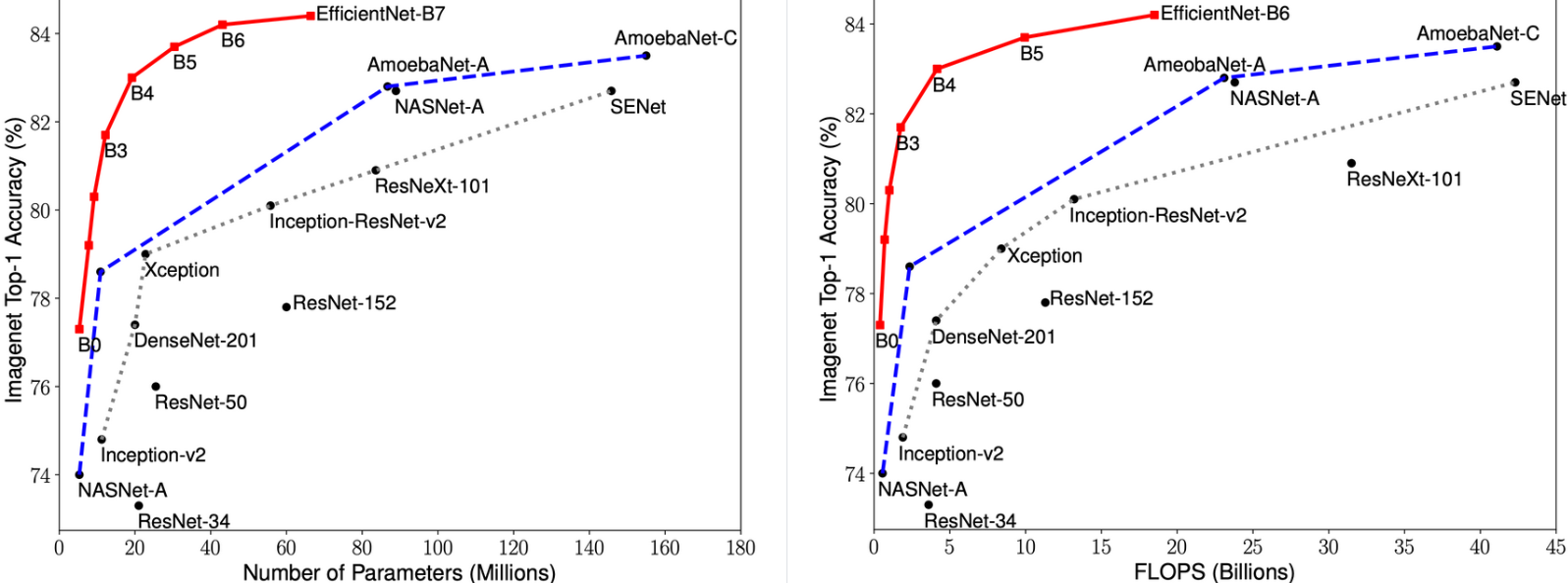

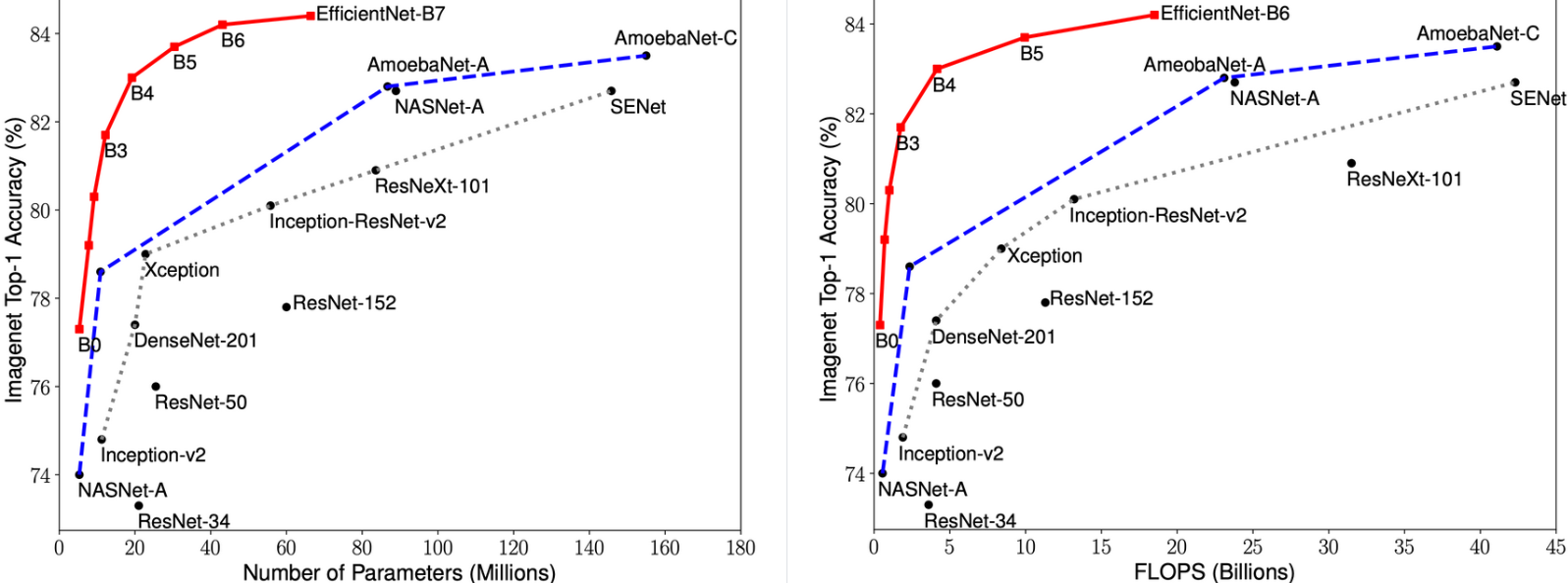

EfficientNet

EfficientNet — класс новых моделей, который получился из изучения масштабирования (скейлинг, scaling) моделей и балансирования между собой глубины и ширины (количества каналов) сети, а также разрешения изображений в сети. Авторы

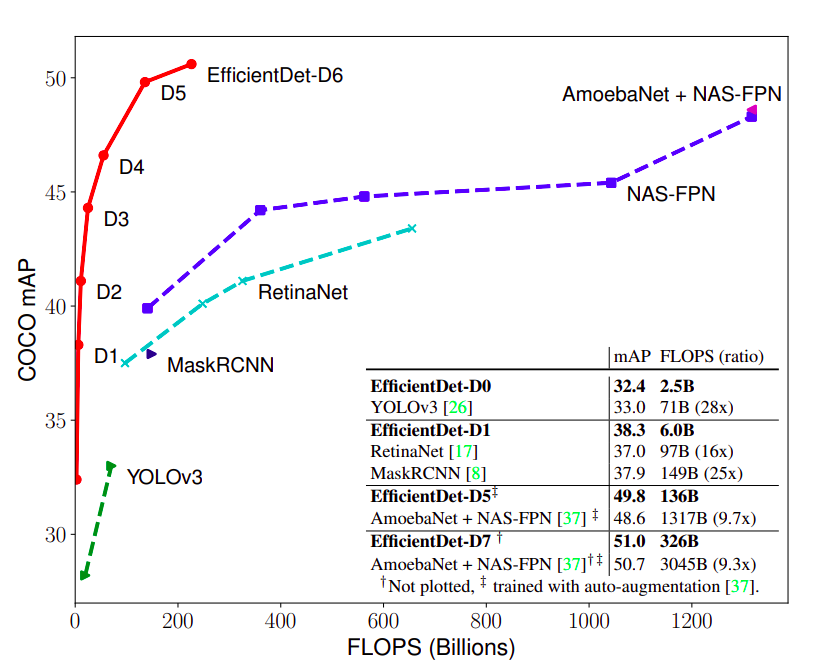

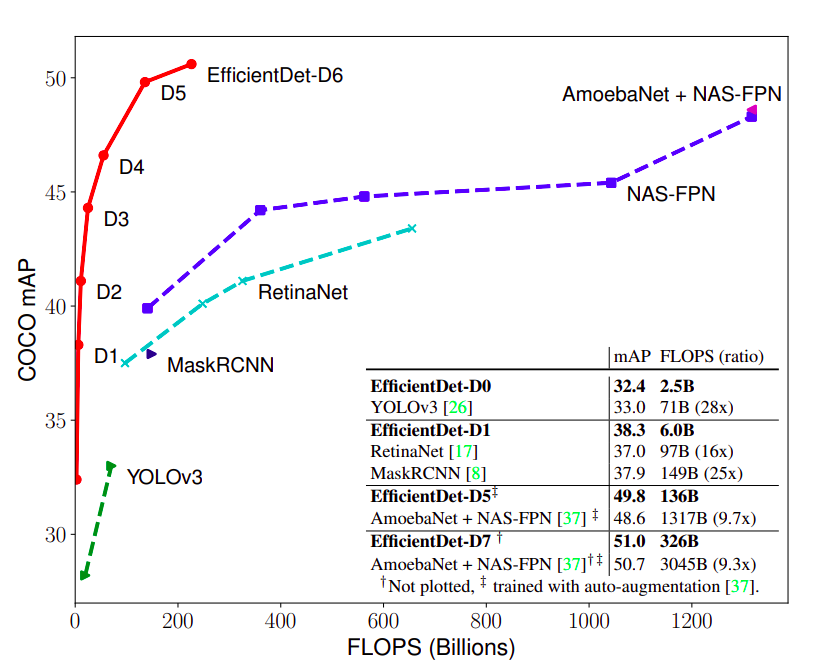

EfficientDet

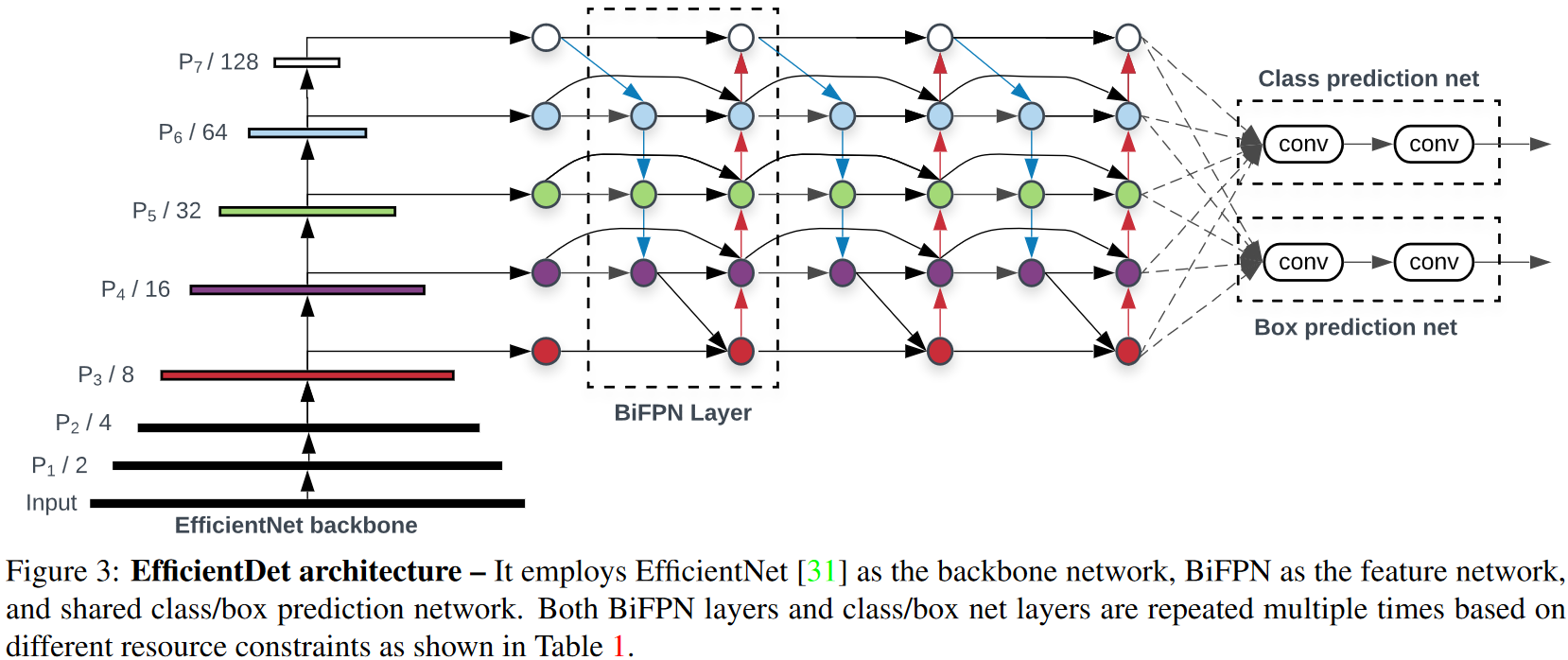

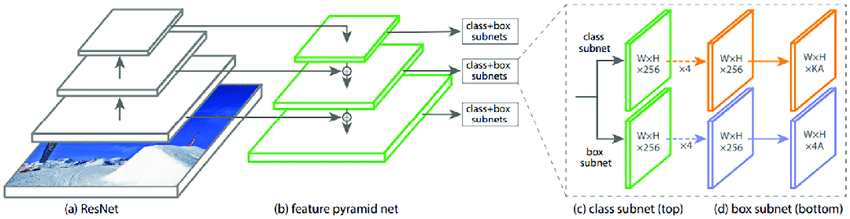

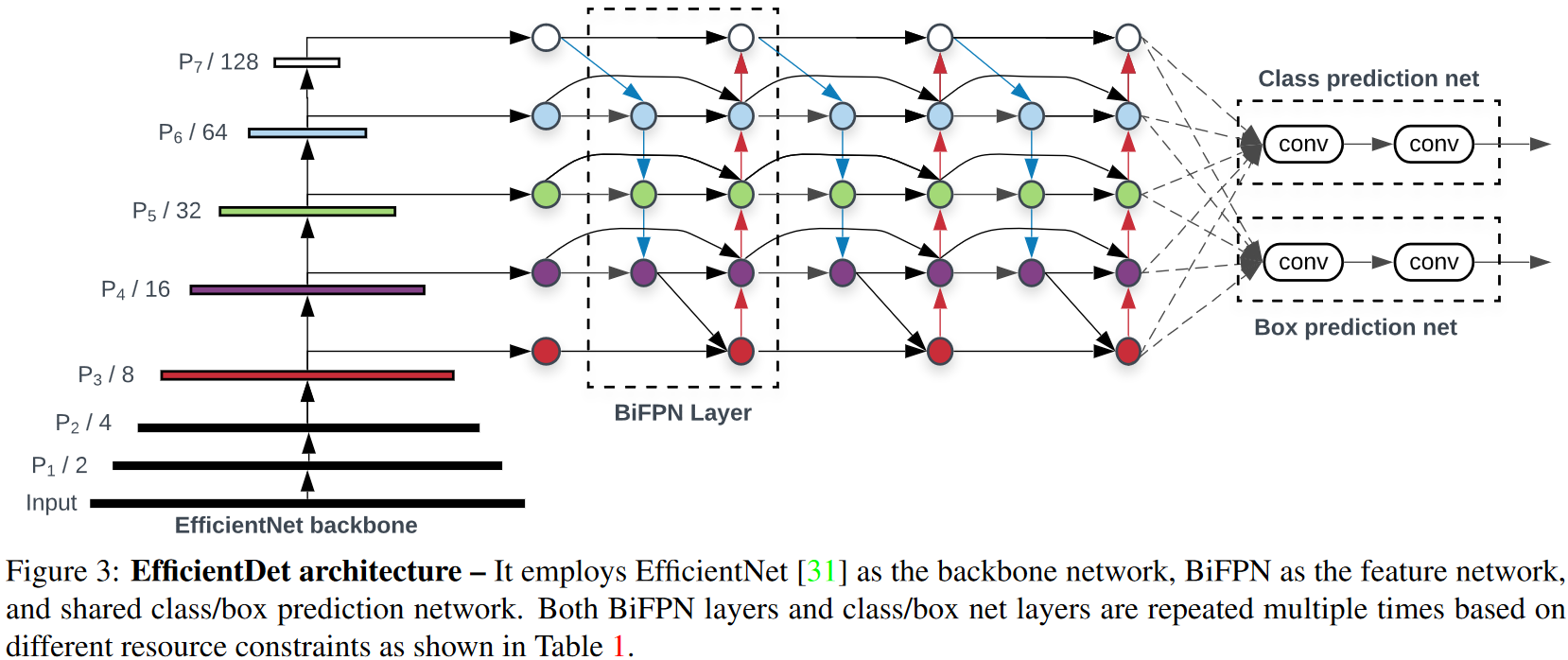

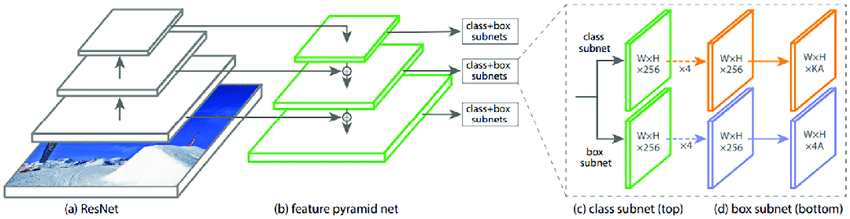

EfficientDet применяется для обнаружения объектов. Архитектура показана на рисунке ниже. Состоит из

Рисунок — Архитектура EfficientDet == EfficientNet + BiFPN + сеть вычисления класс/рамка

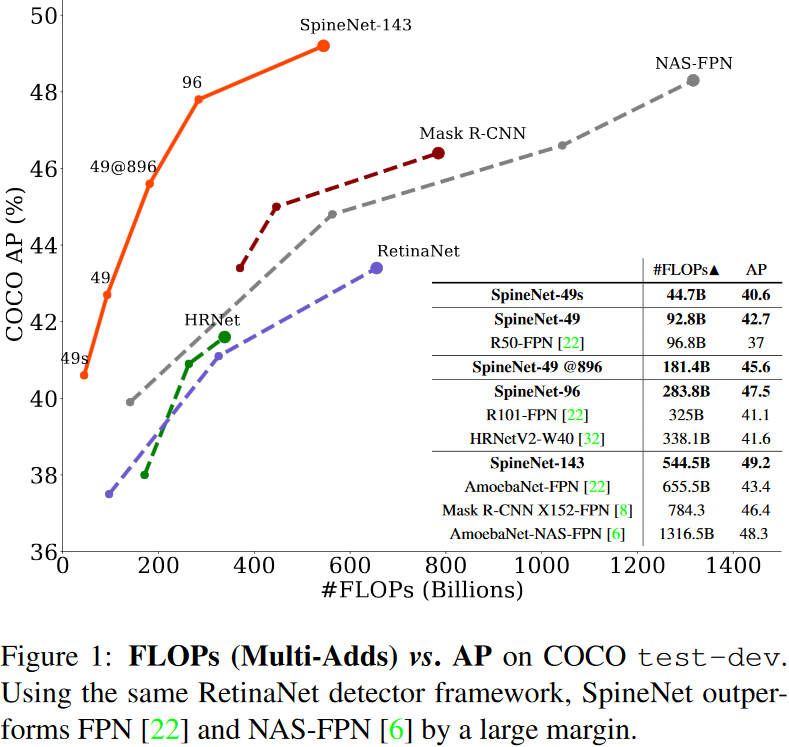

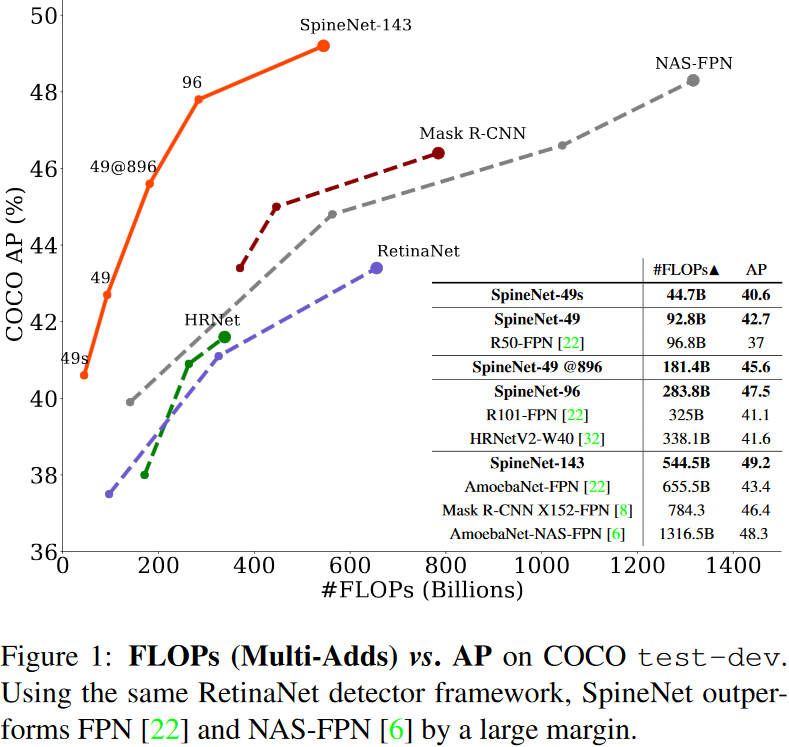

SpineNet

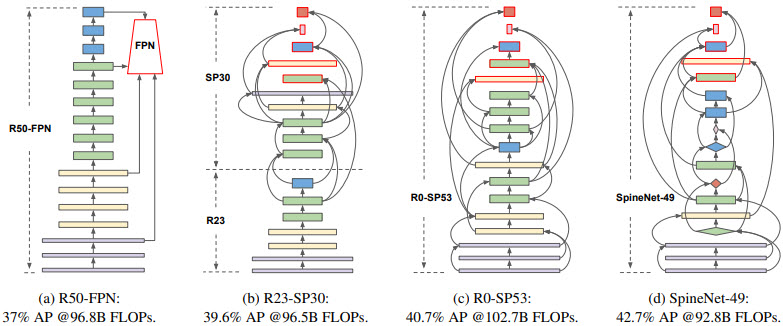

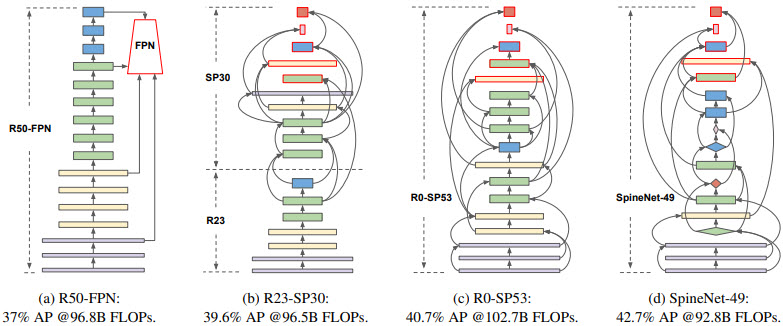

SpineNet применяется для обнаружения объектов на изображении. Исследователи из Google Research достигли хороших результатов, которые превышают имеющиеся state-of-the-art (SOTA) подходы.

Сверточные нейросети обычно кодируют входное изображение в последовательность промежуточных признаков меньшей размерности. Такой подход хорошо работает для задачи классификации изображений, но плохо работает для задачи распознавания объектов (распознавание и локализация). Для обхода ограничения сверточных сетей по локализации (сегментации) объектов применяются сверточные кодировщик-декодировщик с архитектурой типа «

Предложенная модель SpineNet позволяет выучивать разномасштабные признаки из-за сверточных слоев смешанных размеров (смотрите рисунок ниже). Размеры слоев подбирались с помощью нейронного поиска архитектур (Neural Architecture Search, NAS). Использование SpineNet в качестве базовой модели дает прирост в точности (Average Precision, AP). При этом на обучение модели требуется меньше вычислительных ресурсов.

Рисунок – Построение моделей со смешанным масштабом с помощью перестановок слоев архитектуры ResNet (ResNet-50-FPN крайняя слева)

CenterNet

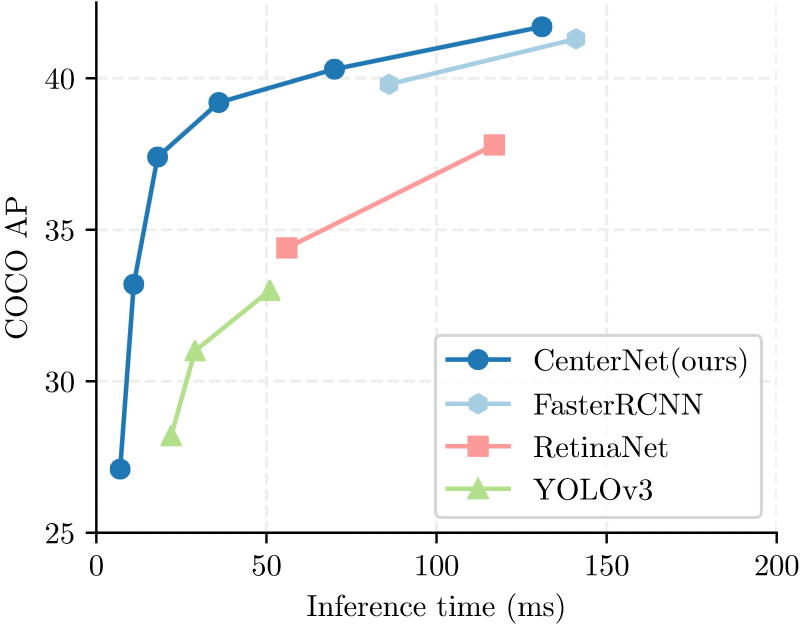

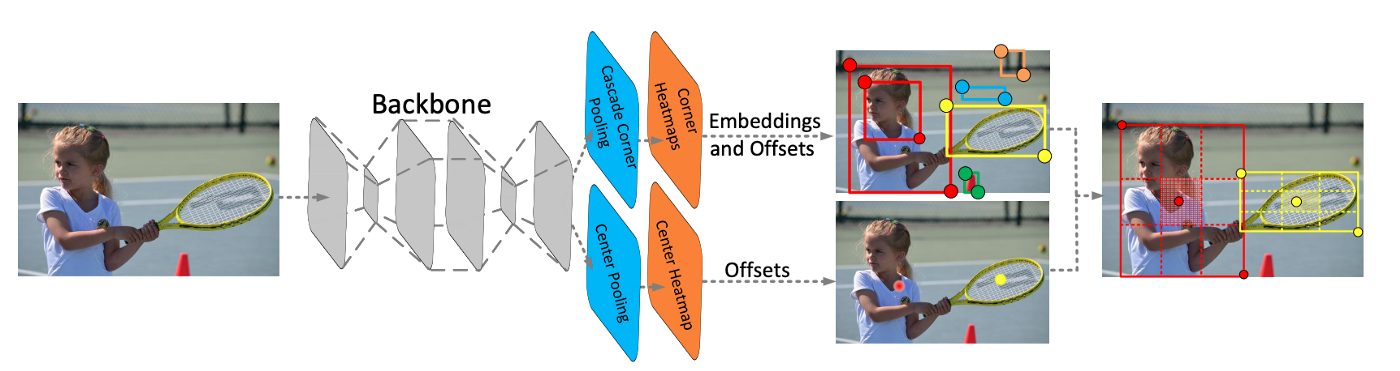

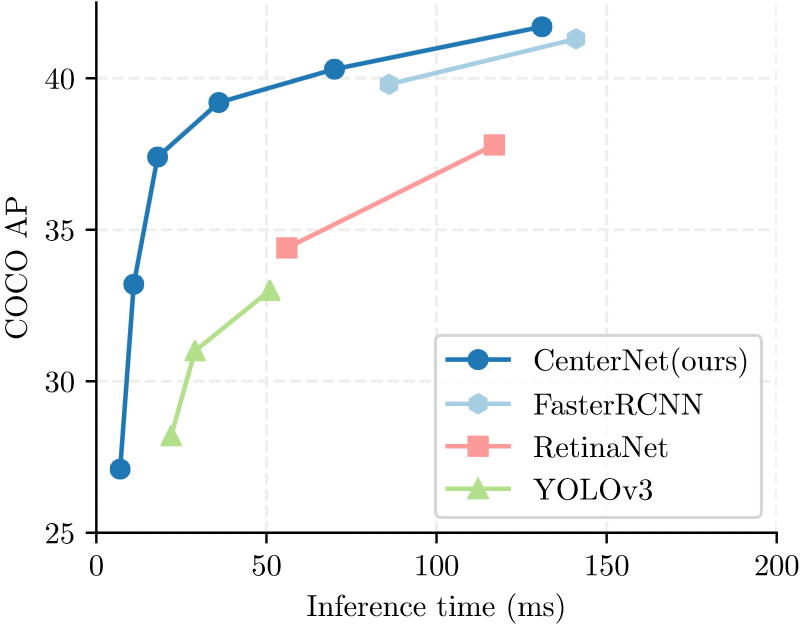

CenterNet и CornerNet-Lite считались на 2019 год мейнстримовыми легковесными системами обнаружения объектов в реальном времени (cтатья «

CenterNet моделирует объект, как одну точку, которая находится в центре ограничительной рамки. Размер объекта, его ориентация, 3D-форма, направление, поза и т.д. извлекаются в последствии через характеристики изображения (image features) около полученной точки. Авторы подают входное изображение в полносвязную сверточную сеть, которая генерирует тепловую карту (heatmap). Пики на этой тепловой карте соответствуют центрам объектов. Характеристики изображения в каждом пике тепловой карты предсказывают размеры ограничительной рамки вокруг объекта. С помощью CenterNet авторы статьи экспериментируют с определением 3D размеров объектов и оценкой позы человека по двумерному изображению.

В другой

Рисунок – Диаграмма CenterNet

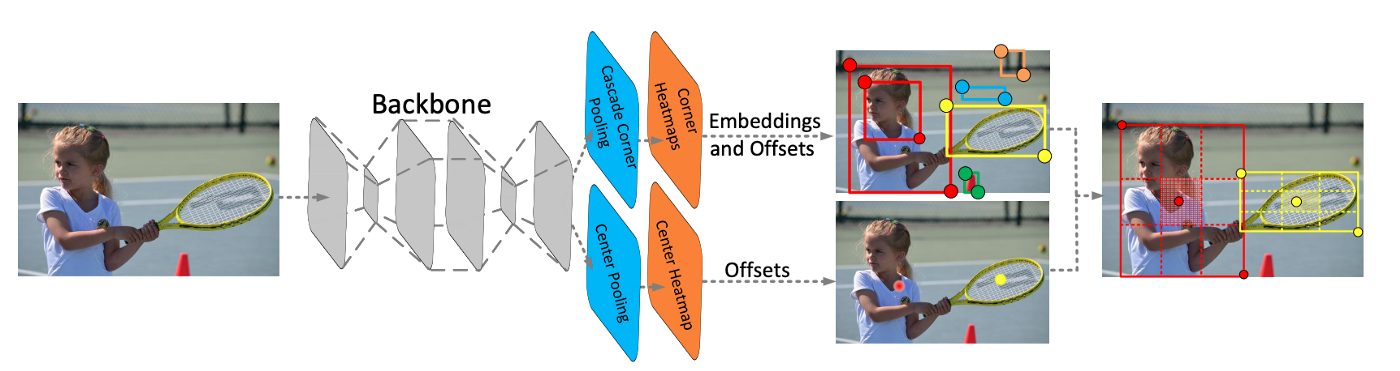

CornerNet является предшественником CenterNet. CornerNet обнаруживает объект, как пару точек: верхний левый и правый нижний углы ограничительной рамки (bounding box). Таким образом распознавание по набору фиксированных рамкок (anchor box), как у нейросетей SSD и YOLO, заменяется на определение пары точек верхнего левого и правого нижнего углов ограничительной рамки вокруг объекта. Также авторы предлагают архитектуру на основе последовательности нескольких нейросетей типа «песочные часы», которые до этого не использовались для определения объектов.

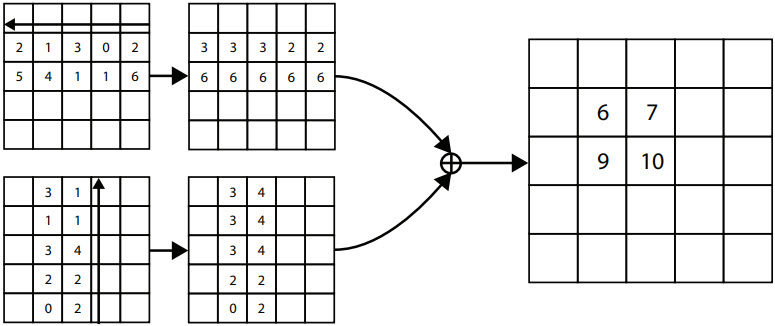

В CornerNet применяется механизм «corner pooling» для определения углов ограничительной рамки вокруг объектов. В CenterNet добавляется механизм «center pooling» для определения центра рамки.

Рисунок – Механизм «corner pooling» для верхнего левого угла. Сканирование проходит справа налево для горизонтального «max-pooling» и снизу вверх для вертикального «max-pooling». Затем две карты характеристик (feature maps) слаживаются.

ThunderNet

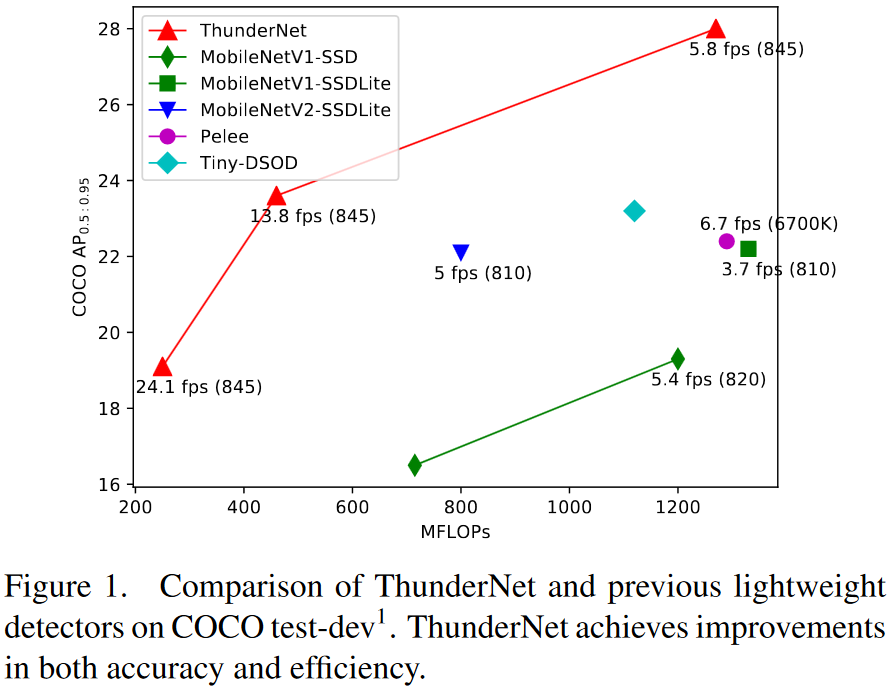

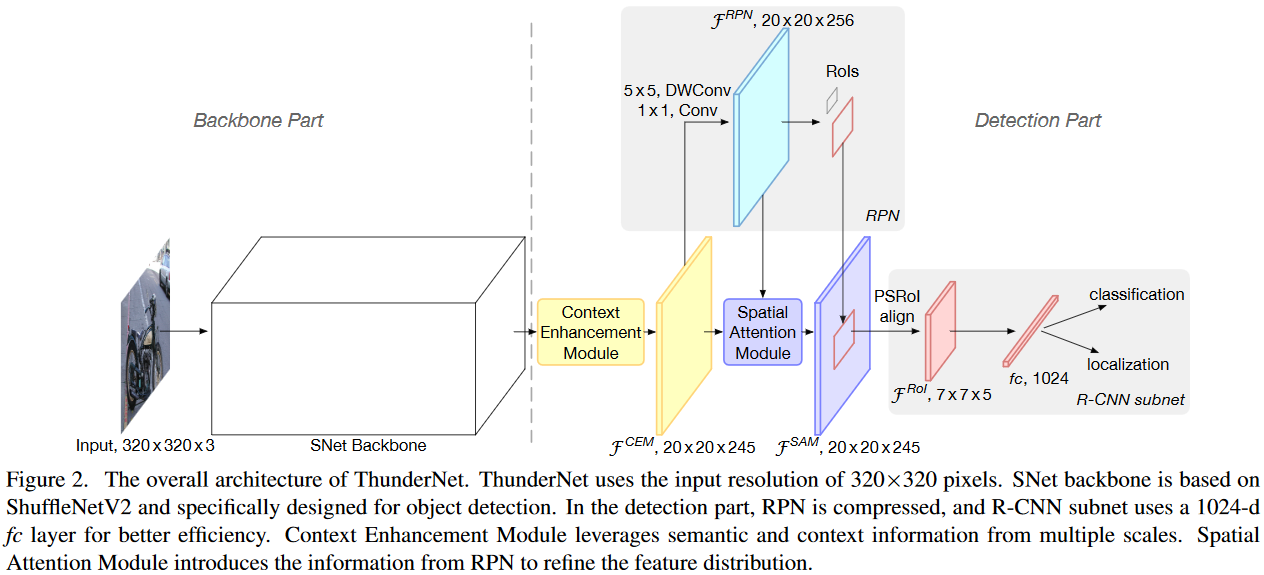

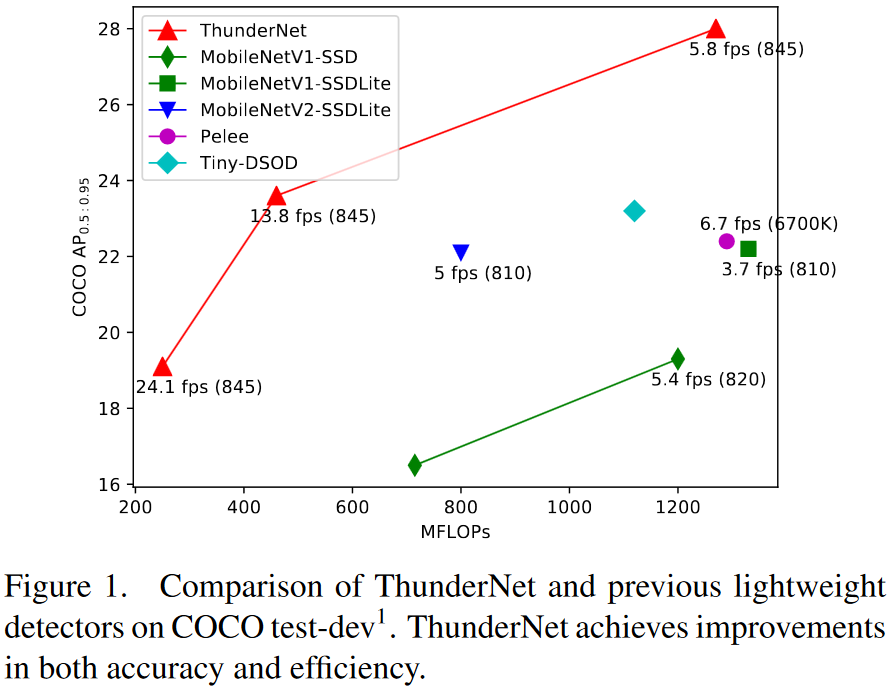

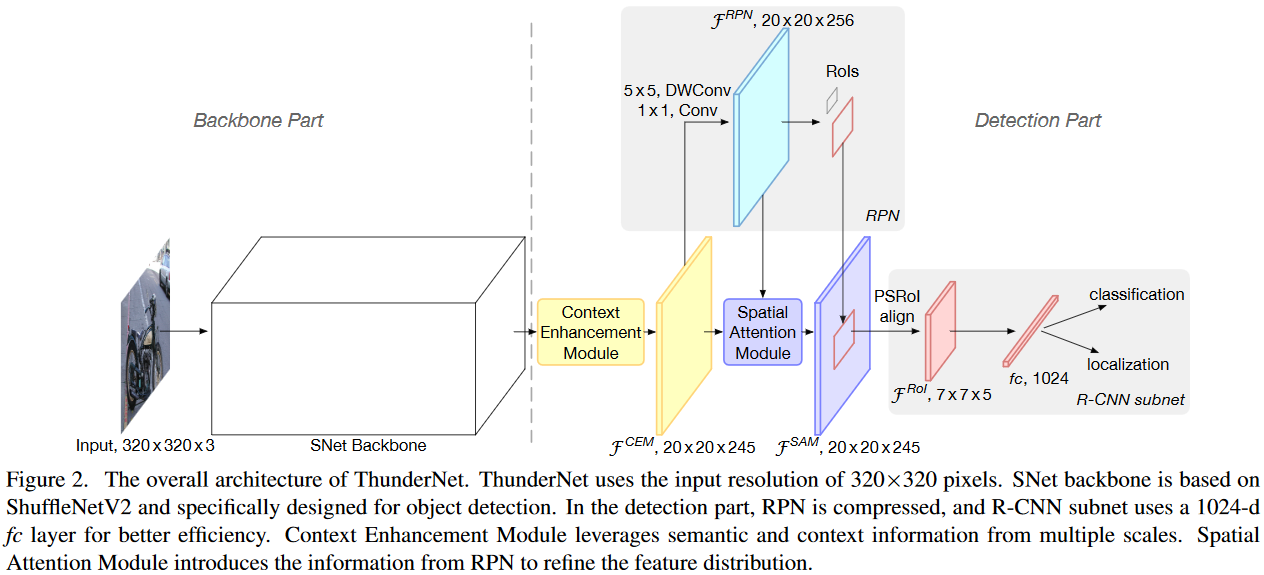

ThunderNet применяется для обнаружения объектов на изображении. Является легковесным двуступенчатым детектором. Как утверждают авторы, является первым детектором объектов в реальном времени, который был запущен на платформах

Рисунок — Архитектура ThunderNet

CSPNet

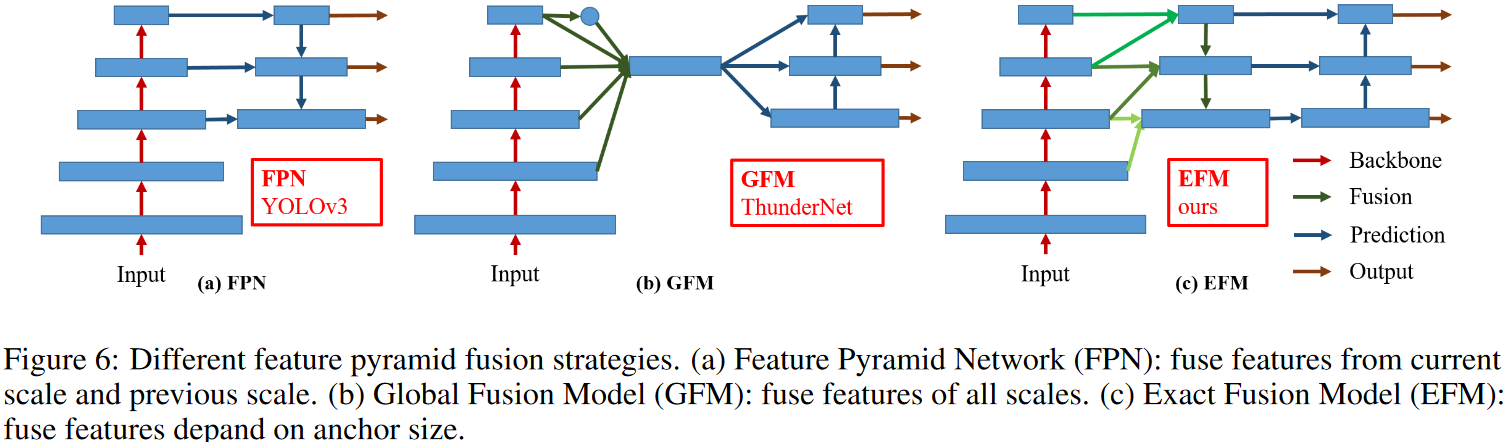

CSPNet (Cross Stage Partial Network) работает на фреймворке

Рисунок — Пример пирамиды признаков

DenseNet

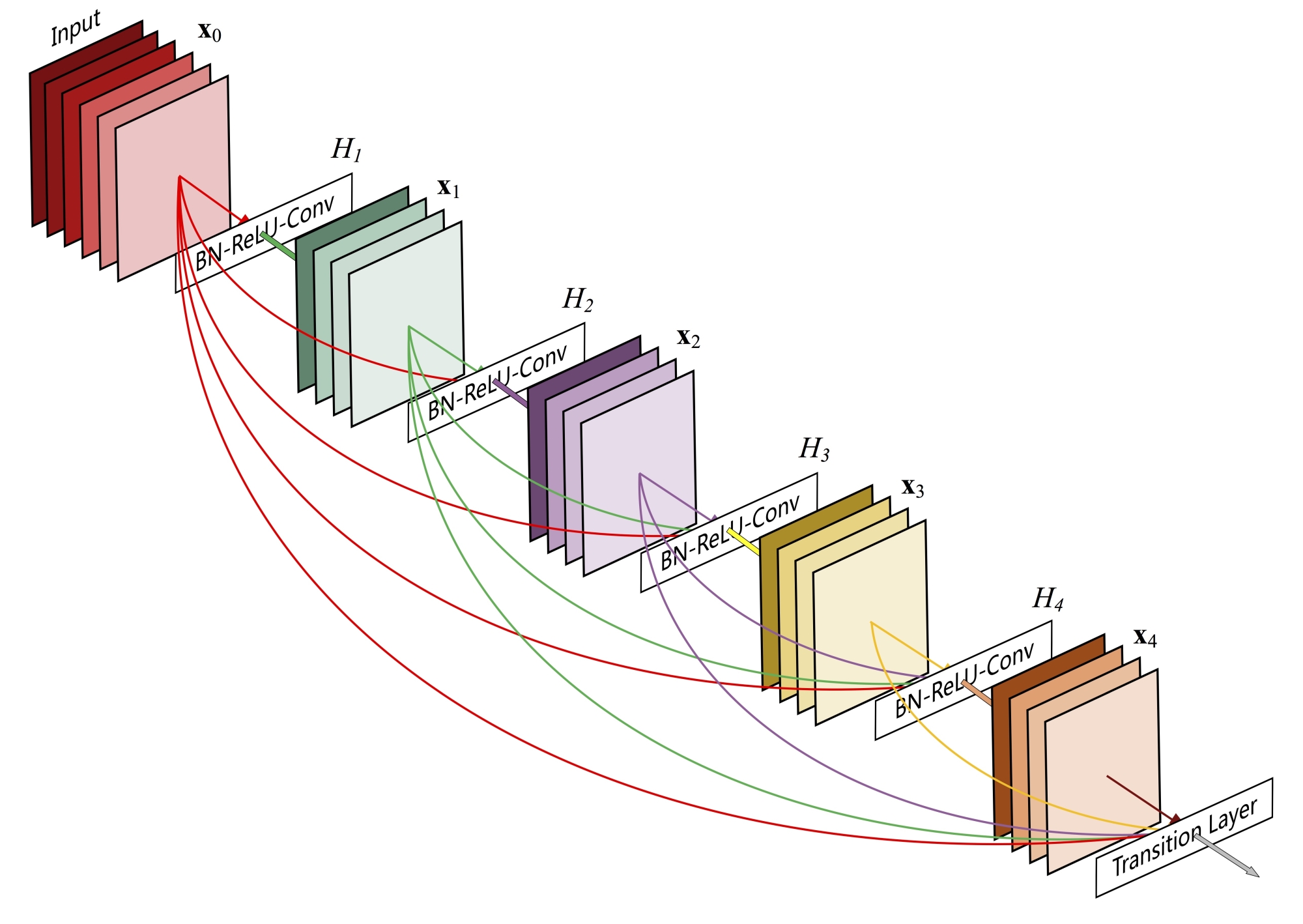

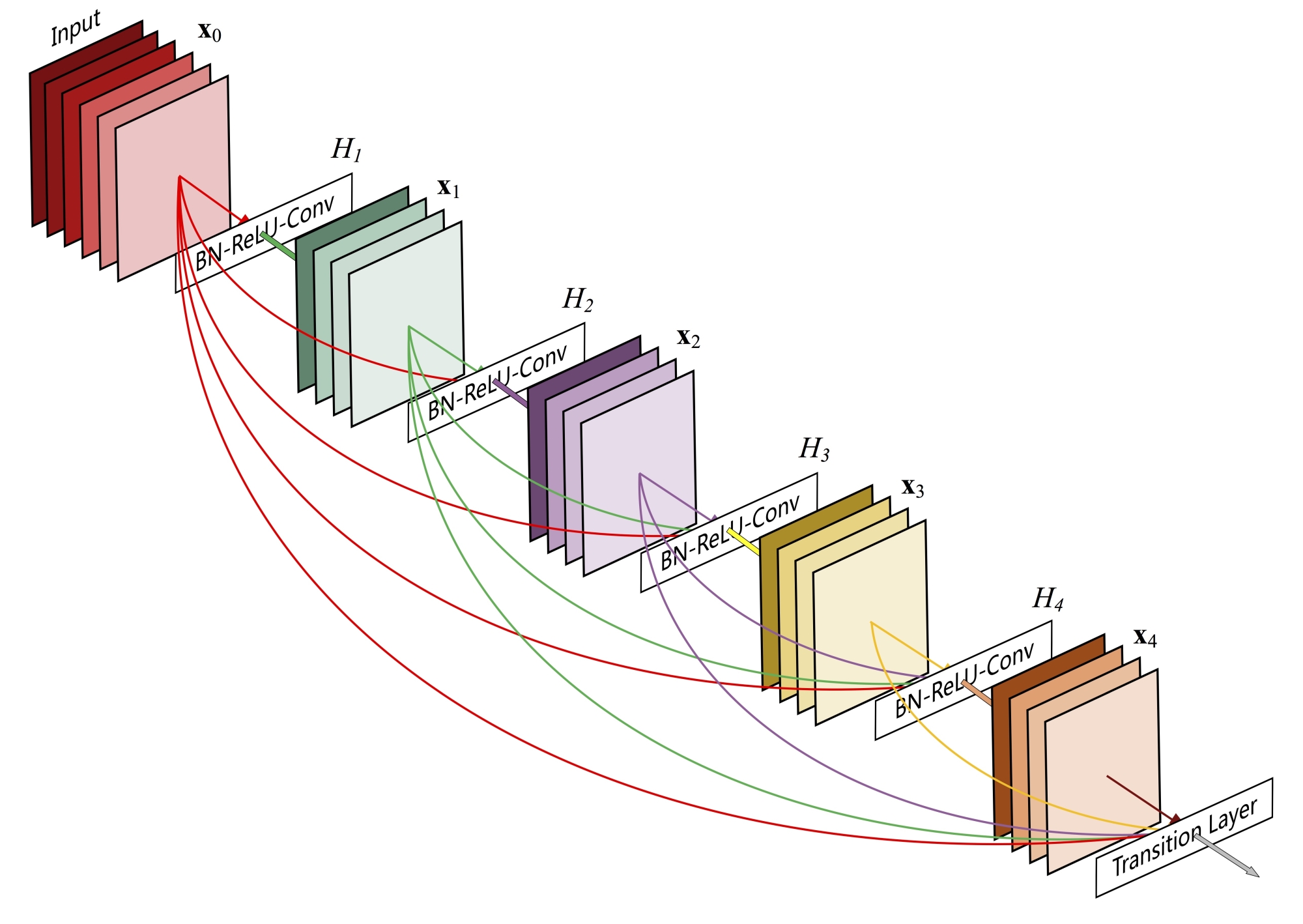

Рисунок — Один плотный блок DenseNet c 5 слоями и скоростью роста k = 4. Каждый слой принимает все предыдущие карты признаков в качестве входных данных.

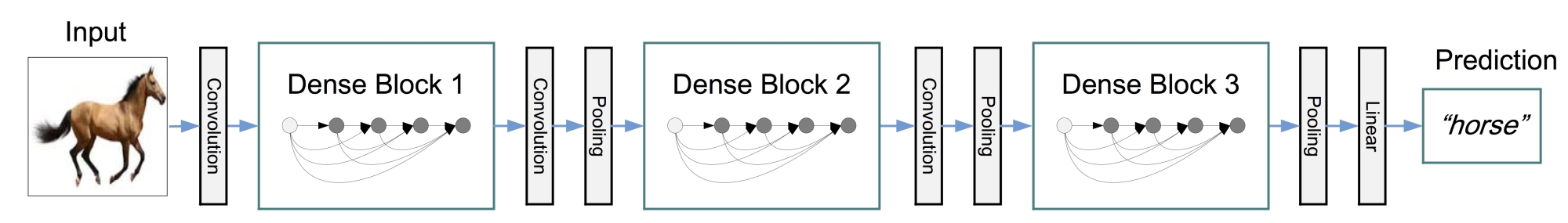

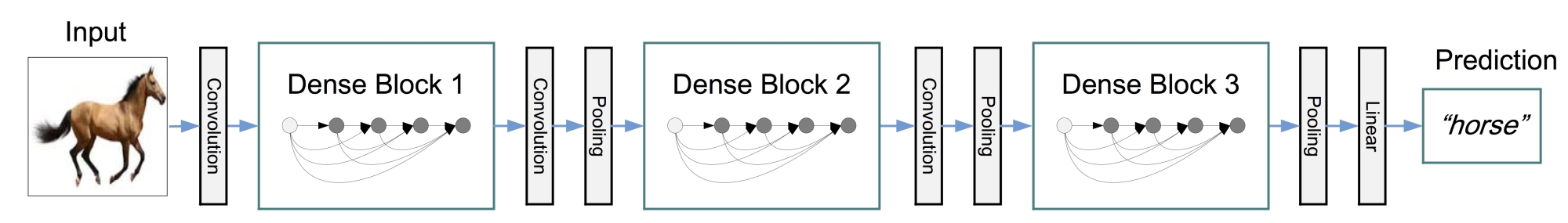

Рисунок — DenseNet с тремя плотными блоками

DenseNet (Densely Connected Convolutional Network) была предложена в 2017 году. Успех ResNet (Deep Residual Network) позволил предположить, что укороченное соединение в CNN позволяет обучать более глубокие и точные модели. Авторы проанализировали это наблюдение и представили компактно соединенный (dense) блок, который соединяет каждый слой с каждым другим слоем. Важно отметить, что, в отличие от ResNet, признаки («фичи») прежде чем они будут переданы в следующий слой не суммируются, а конкатенируются (объединяются, channel-wise concatenation) в единый тензор. При этом количество параметров сети DenseNet намного меньше, чем у сетей с такой же точностью работы. Авторы

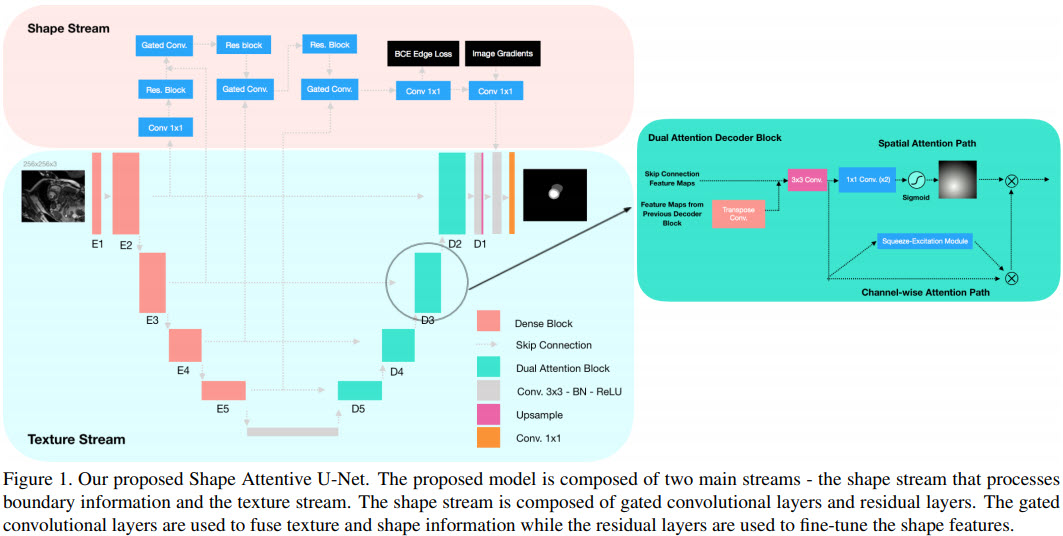

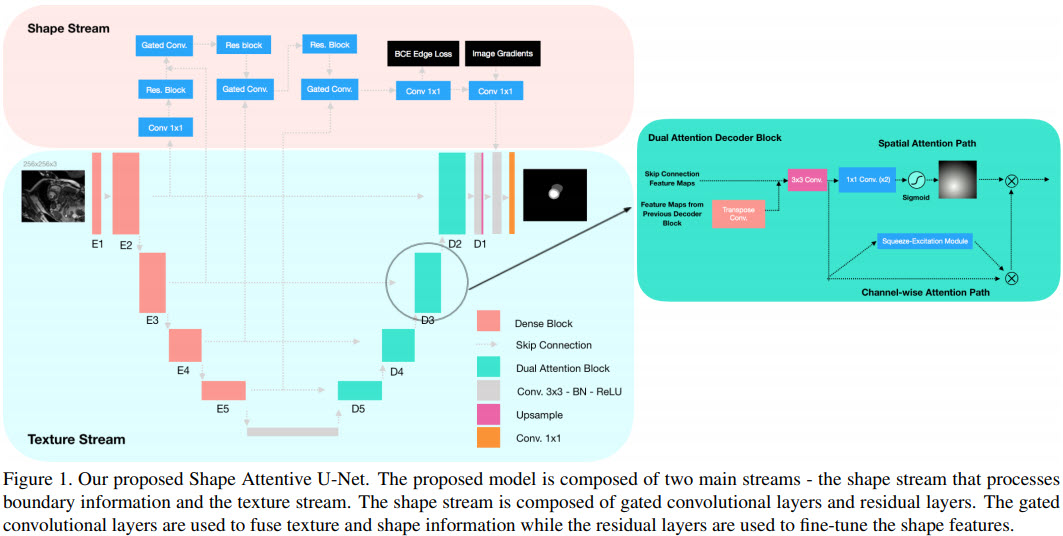

SAUNet

SAUNet (Shape Attentive U-Net) показывает наилучшие на начало 2020 года результаты по сегментации изображений МРТ сердца и предлагается автомами, как сеть по сегментации медицинских изображений.

Рисунок — SAUNet состоит из двух частей: одна часть обрабатывает текстуры (texture stream); вторая часть обрабатывает формы (gated shape stream). В кодировщике текстур сети U-Net используются блоки DenseNet-121 (смотрите выше

Архитектура SAUNet является модульной и состоит из многих различных блоков:

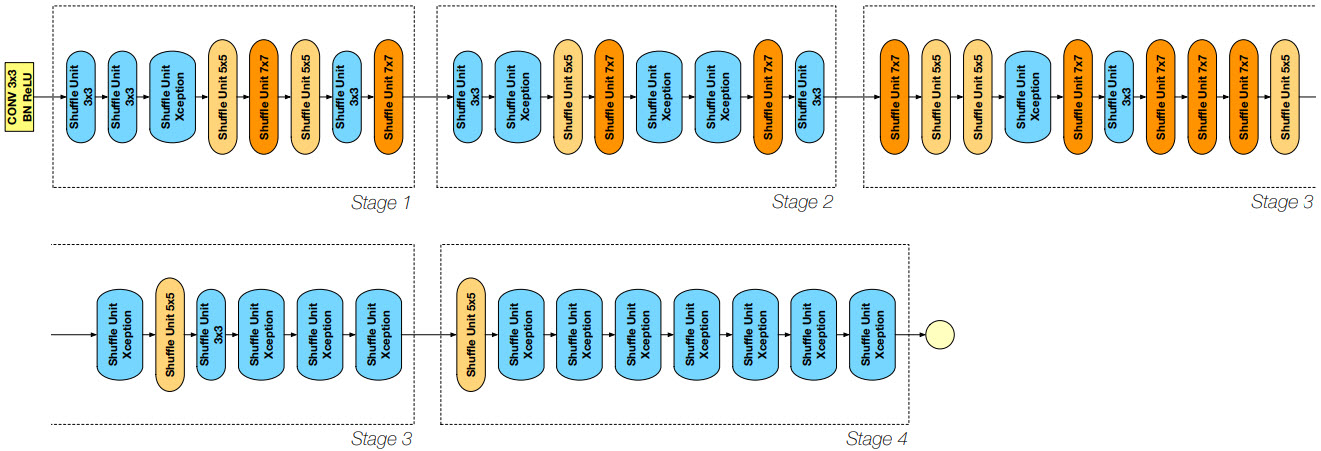

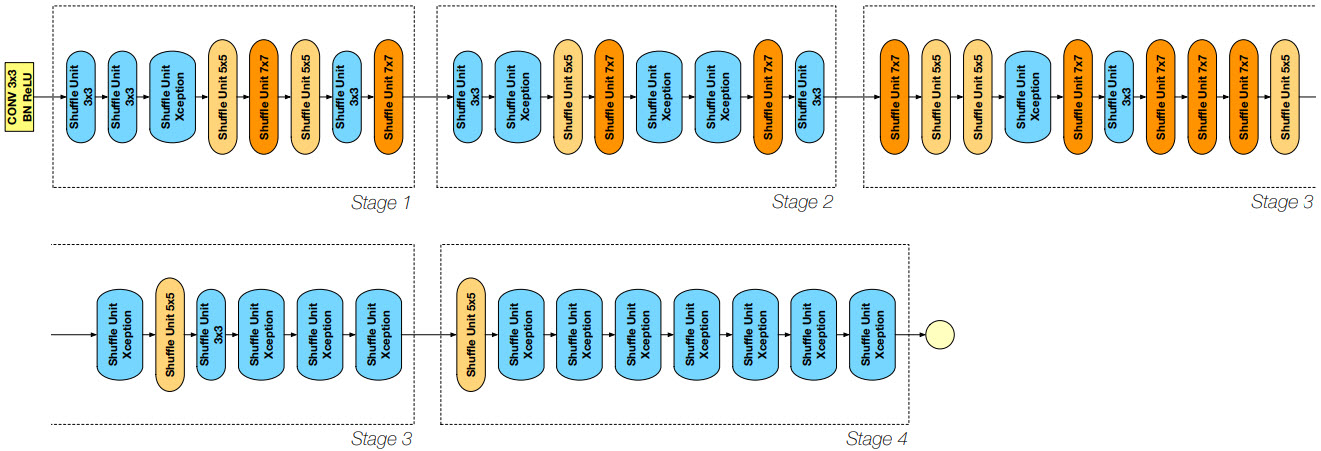

DetNASNet

Рисунок — Архитектура DetNASNet

Многие детекторы объектов работают на сетях, которые спроектированы для классификации изображений, что не оптимально, потому что определение объектов (object detection) и классификация изображений (image classification) являются различными задачами. DetNASNet использует подход под названием Neural Architecture Search (

SM-NAS

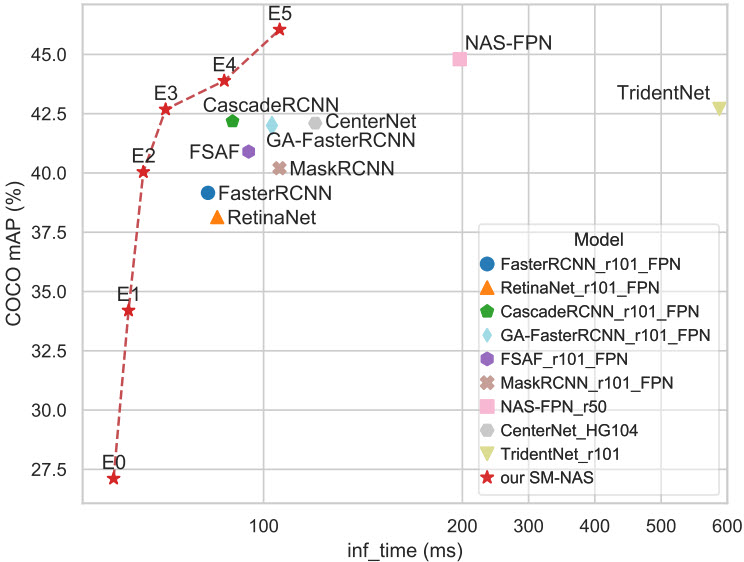

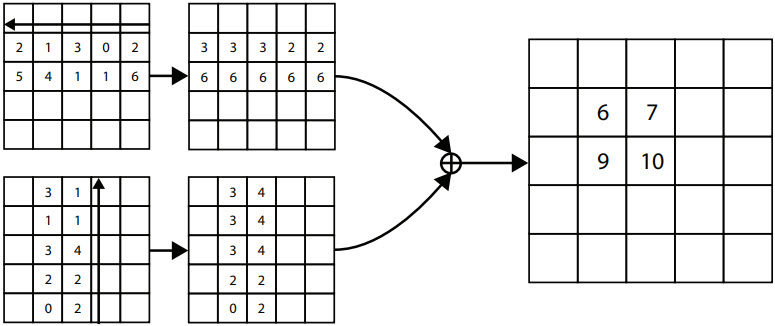

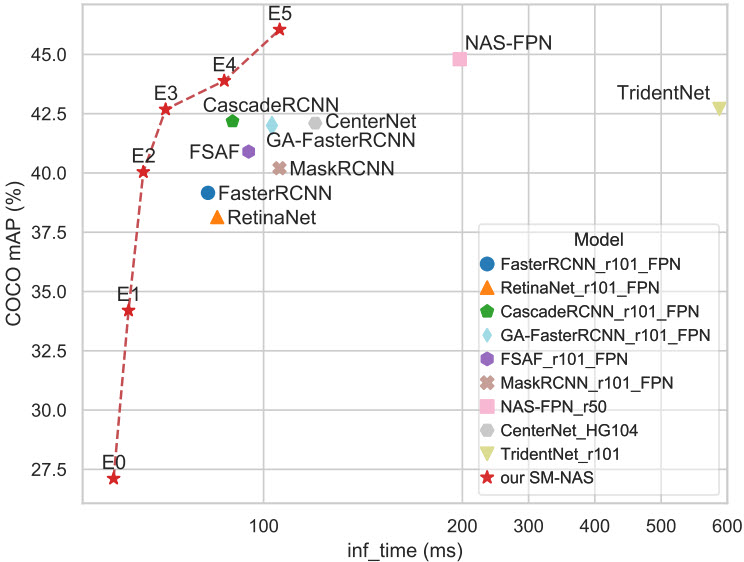

Рисунок — Сравнение времени вывода (мс) и точности обнаружения (mAP) на наборе данных COCO.

В SM-NAS предлагается двухэтапная стратегия грубого поиска под названием Structural-to-Modular NAS (SM-NAS): первый этап поиска на структурном уровне направлен на поиск эффективной комбинации различных модулей; второй этап поиска на модульном уровне развивает каждый конкретный модуль и продвигает

AmoebaNet

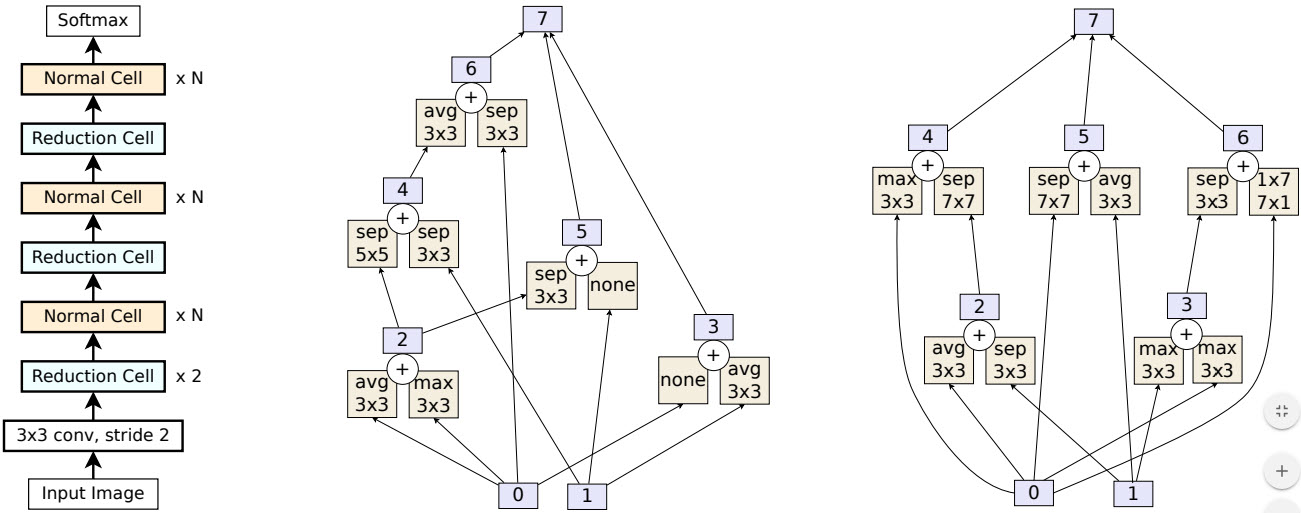

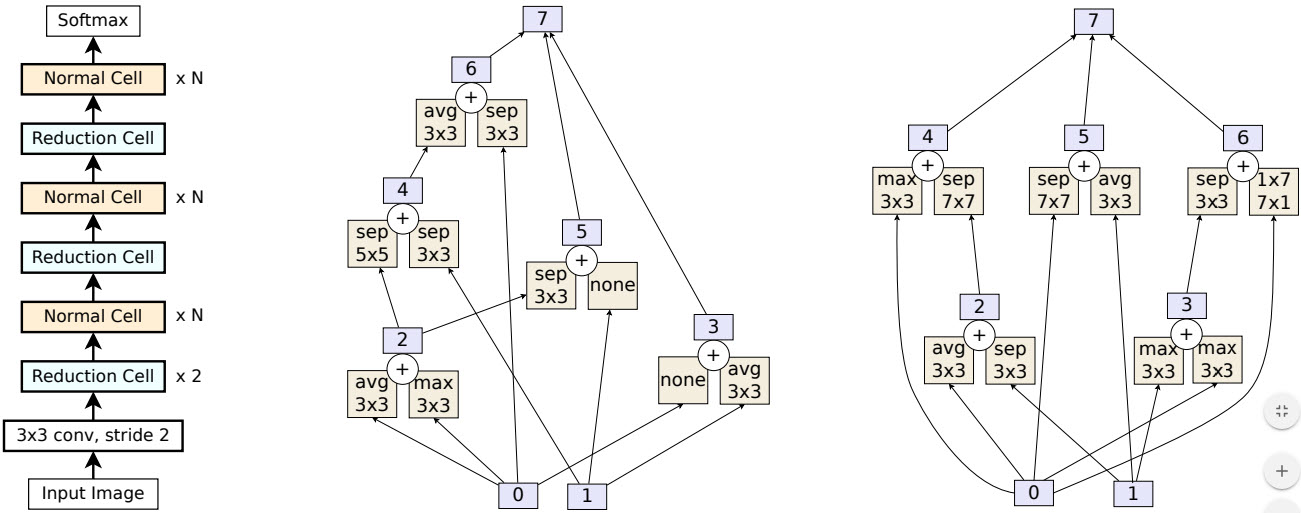

Рисунок — Архитектура сети AmoebaNet-A. Слева общая модель. В центре блок «Normal Cell». Справа блок «Reduction Cell».

AmoebaNet также относится к алгоритмам по автоматическому созданию нейросетей. AmoebaNet использует

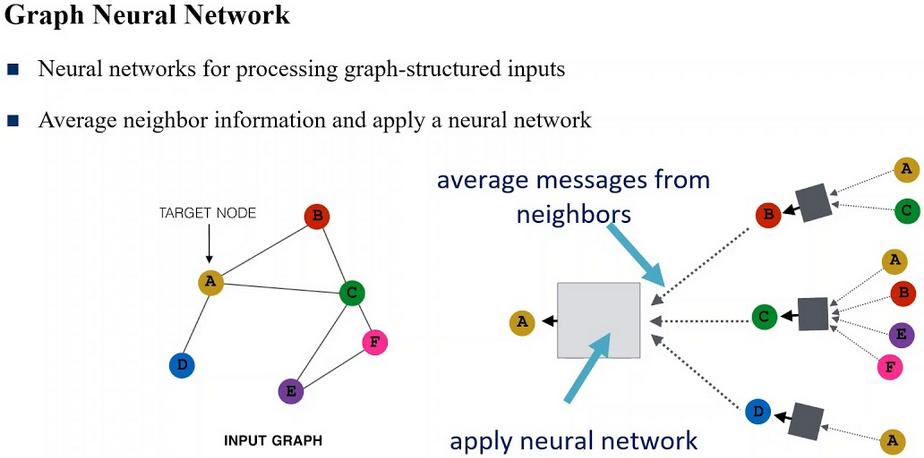

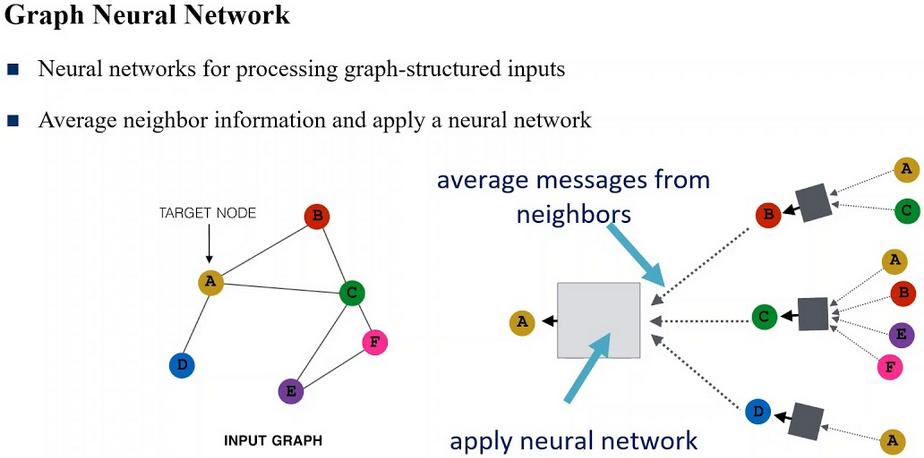

Graph Neural Network

Graph Neural Network или нейронная сеть на графе, где искусственные нейроны — это узлы графа, а соединения между нейронами — это ребра графа. Полезны для решения задач машинного обучения на графах, т.е. если задачу можно представить в виде какого-нибудь графа. А на графах можно сделать очень многое и даже прововодить обработку изображений. Наиболее популярные библиотеки для машинного обучения на графах:

Growing Neural Cellular Automata

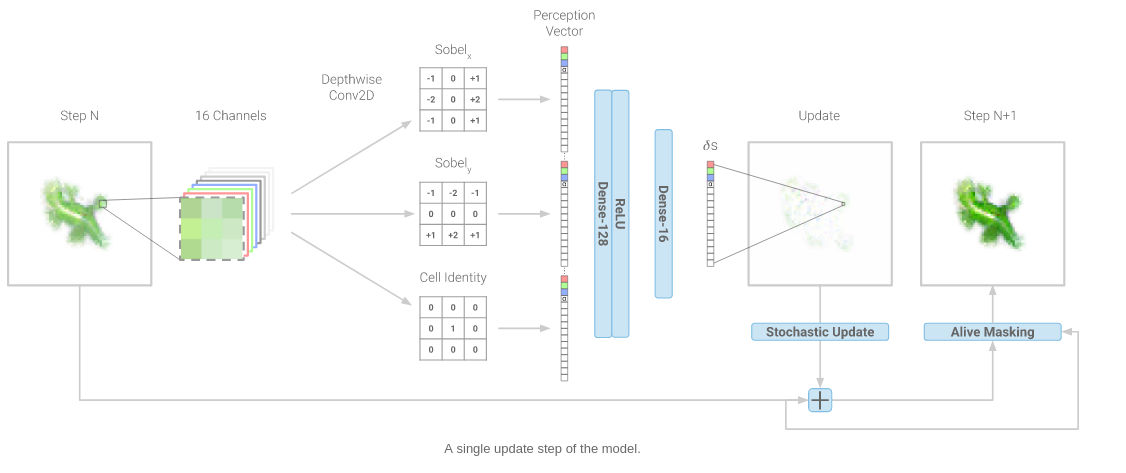

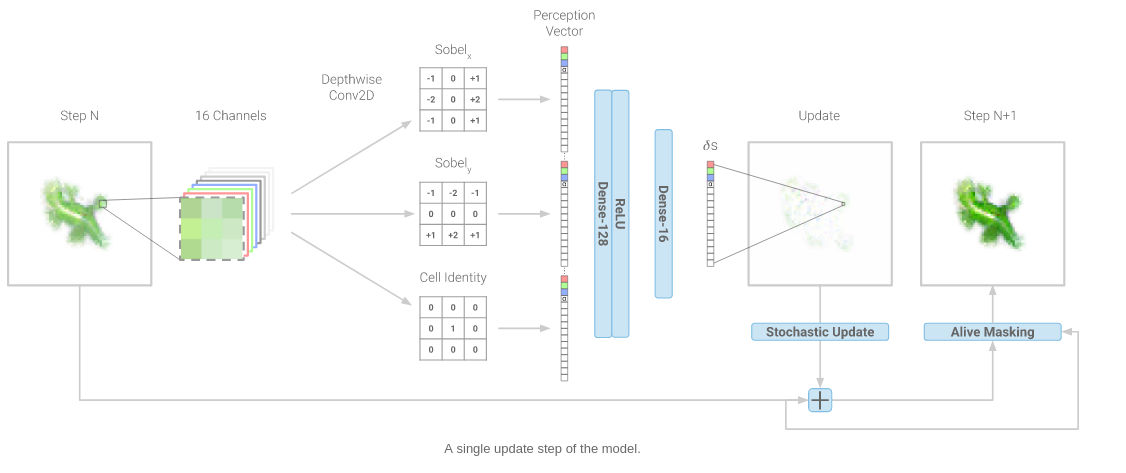

Рисунок — Один шаг обновления модели

Growing Neural Cellular Automata являются скрещением идей клеточных автоматов и искусственных нейронных сетей, результатом которого являются «живые» самовоспроизводящиеся и взаимодействующие друг с другом изображения. Ничто не мешает вместо изображений взять любые другие объекты (текст, музыку и т.д.). Растущие нейронные клеточные автоматы выглядят привлекательно и эффектно. Изображения «выращиваются» из вектора в 16 чисел с плавающей запятой. Таким образом данные могут быть «упаковываны» в компактную цепочку чисел, как код ДНК, что в будущем может составить конкуренцию форматам сжатия данных типа JPEG (изображения), MP3 (звук), MPEG (видео) и ZIP (текст).

В

Импульсная нейронная сеть

Импульсная нейронная сеть или Spiking neural network является самой реалистичной с точки зрения физиологии. В ней нейроны обмениваются короткими импульсами одинаковой амплитуды. Первая научная модель импульсной нейросети была предложена еще в 1952 году Аланом Ходжкином и Эндрю Хаксли, однако данный вид искусственных нейронных сетей известен немногим специалистам в этой области. Основная идея состоит в том, чтобы скопировать поведение биологическкого нейрона. Такие модели могут быть полезны при изучении функций мозга. Для того, чтобы быстро летать, необязательно махать крыльями, однако при решении прикладных задач некоторые свойства можно позаимствовать у биологических организмов.

DPM

DPM, Deformable Part Model detector, не нейросеть. Использует

Сотни готовых «классических» алгоритмов могут использоваться для предварительной обработки и постобработки данных, как дополнение к нейросетям, которое обеспечивает новый синтез идей, и даже вместо нейросетей. Например, в

Выводы

P.S. Рекомендую видео блог

Спасибо за внимание!

Предыдущая статья «

You must be registered for see links

»В этой статье кратко рассматриваются некоторые архитектуры нейросетей, в основном по задаче обнаружения объектов, чтобы найти (или хотя бы попытаться найти) будущие направления в этой быстро развивающейся области.

Статья не претендует на полноту охвата и хорошее понимание прочитанных «по диагонали» статей. Автор уверен, что пока писал эту статью, появилось еще много новых архитектур. Например, смотрите здесь:

You must be registered for see links

.-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

-

You must be registered for see links

You must be registered for see links

— большой обзор на 400+ статей для обнаружения объектов за 20 лет.

You must be registered for see links

— зоопарк нейросетей, содержимое которого постоянно меняется.Интересное видео с рекомендациями, как спроектировать нейронную сеть: «

You must be registered for see links

».EfficientNet

EfficientNet — класс новых моделей, который получился из изучения масштабирования (скейлинг, scaling) моделей и балансирования между собой глубины и ширины (количества каналов) сети, а также разрешения изображений в сети. Авторы

You must be registered for see links

предлагают новый метод составного масштабирования (compound scaling method), который равномерно масштабирует глубину/ширину/разрешение с фиксированными пропорциями между ними. Из существующего метода под названием «Neural Architecture Search» (

You must be registered for see links

,

You must be registered for see links

,

You must be registered for see links

,

You must be registered for see links

) для автоматического создания новых сетей и своего собственного метода масштабирования авторы получают новый класс моделей под названием EfficientNets.-

You must be registered for see links«EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks»

- обзор оригинальной статьи

You must be registered for see links

-

You must be registered for see linksдля TensorFlow

-

You must be registered for see links,You must be registered for see links,You must be registered for see links,You must be registered for see links

EfficientDet

EfficientDet применяется для обнаружения объектов. Архитектура показана на рисунке ниже. Состоит из

You must be registered for see links

в качестве основы, к которой приделан слой по работе с пирамидой признаков под названием BiFPN, за которым идет «стандартная» сеть вычисления класс/рамка объекта.

Рисунок — Архитектура EfficientDet == EfficientNet + BiFPN + сеть вычисления класс/рамка

-

You must be registered for see links«EfficientDet: Scalable and Efficient Object Detection»

-

You must be registered for see linksдля TensorFlow

-

You must be registered for see linksдля PyTorch

-

You must be registered for see links

SpineNet

SpineNet применяется для обнаружения объектов на изображении. Исследователи из Google Research достигли хороших результатов, которые превышают имеющиеся state-of-the-art (SOTA) подходы.

Сверточные нейросети обычно кодируют входное изображение в последовательность промежуточных признаков меньшей размерности. Такой подход хорошо работает для задачи классификации изображений, но плохо работает для задачи распознавания объектов (распознавание и локализация). Для обхода ограничения сверточных сетей по локализации (сегментации) объектов применяются сверточные кодировщик-декодировщик с архитектурой типа «

You must be registered for see links

» (Convolutional Encoder-Decoder Neural Network). В архитектурах типа «песочные часы» декодировщик располагается поверх кодировщика. Таким образом кодировщик применяется для задач классификации, а декодировщик – для задач локализации (сегментации). При этом кодировщик является основной моделью (backbone model), как правило, содержит больше параметров и потребляет больше вычислительных мощностей, чем декодировщик. Исследователи заявляют, что архитектура типа «песочные часы» неэффективна для генерации признаков разных масштабов, потому что в такой модели масштаб изображения постоянно уменьшается при помощи основной модели (кодировщика).Предложенная модель SpineNet позволяет выучивать разномасштабные признаки из-за сверточных слоев смешанных размеров (смотрите рисунок ниже). Размеры слоев подбирались с помощью нейронного поиска архитектур (Neural Architecture Search, NAS). Использование SpineNet в качестве базовой модели дает прирост в точности (Average Precision, AP). При этом на обучение модели требуется меньше вычислительных ресурсов.

Рисунок – Построение моделей со смешанным масштабом с помощью перестановок слоев архитектуры ResNet (ResNet-50-FPN крайняя слева)

-

You must be registered for see links«SpineNet: Learning Scale-Permuted Backbone for Recognition and Localization»

-

You must be registered for see links«SpineNet: архитектура для распознавания и локализации объекта на изображении»

-

You must be registered for see links

CenterNet

CenterNet и CornerNet-Lite считались на 2019 год мейнстримовыми легковесными системами обнаружения объектов в реальном времени (cтатья «

You must be registered for see links

»).CenterNet моделирует объект, как одну точку, которая находится в центре ограничительной рамки. Размер объекта, его ориентация, 3D-форма, направление, поза и т.д. извлекаются в последствии через характеристики изображения (image features) около полученной точки. Авторы подают входное изображение в полносвязную сверточную сеть, которая генерирует тепловую карту (heatmap). Пики на этой тепловой карте соответствуют центрам объектов. Характеристики изображения в каждом пике тепловой карты предсказывают размеры ограничительной рамки вокруг объекта. С помощью CenterNet авторы статьи экспериментируют с определением 3D размеров объектов и оценкой позы человека по двумерному изображению.

В другой

You must be registered for see links

исследователи используют 3 точки: левый верхний угол, правый нижний угол и центр объекта для более точного определения положения объекта.

Рисунок – Диаграмма CenterNet

CornerNet является предшественником CenterNet. CornerNet обнаруживает объект, как пару точек: верхний левый и правый нижний углы ограничительной рамки (bounding box). Таким образом распознавание по набору фиксированных рамкок (anchor box), как у нейросетей SSD и YOLO, заменяется на определение пары точек верхнего левого и правого нижнего углов ограничительной рамки вокруг объекта. Также авторы предлагают архитектуру на основе последовательности нескольких нейросетей типа «песочные часы», которые до этого не использовались для определения объектов.

В CornerNet применяется механизм «corner pooling» для определения углов ограничительной рамки вокруг объектов. В CenterNet добавляется механизм «center pooling» для определения центра рамки.

Рисунок – Механизм «corner pooling» для верхнего левого угла. Сканирование проходит справа налево для горизонтального «max-pooling» и снизу вверх для вертикального «max-pooling». Затем две карты характеристик (feature maps) слаживаются.

-

You must be registered for see linksпо CenterNet «CenterNet: Keypoint Triplets for Object Detection» +You must be registered for see links+You must be registered for see links

-

You must be registered for see linksпо CornerNet-Lite «CornerNet-Lite: Efficient Keypoint Based Object Detection» +You must be registered for see links

-

You must be registered for see linksпо CornerNet: «CornerNet: Detecting Objects as Paired Keypoints» +You must be registered for see links+You must be registered for see links

ThunderNet

ThunderNet применяется для обнаружения объектов на изображении. Является легковесным двуступенчатым детектором. Как утверждают авторы, является первым детектором объектов в реальном времени, который был запущен на платформах

You must be registered for see links

(мобильные телефоны и одноплатные компьютеры) со скоростью 24.1 fps (frames per second, кадров в секунду) и точностью сравнимой с MobileNet-SSD.-

You must be registered for see links«ThunderNet: Towards Real-time Generic Object Detection»

-

You must be registered for see linksпоиска примеров в GitHub

Рисунок — Архитектура ThunderNet

CSPNet

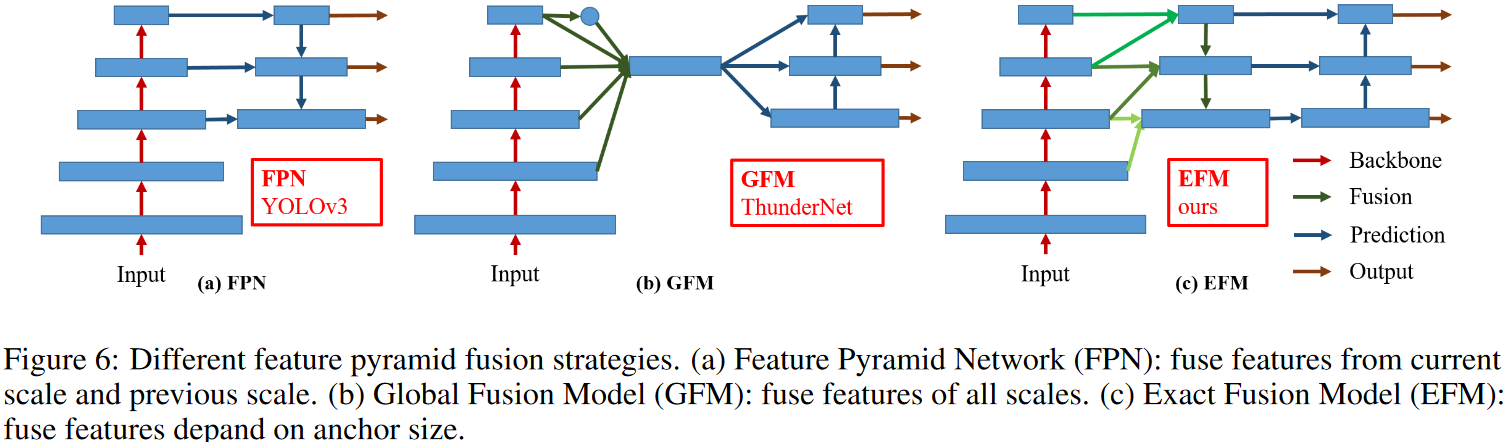

CSPNet (Cross Stage Partial Network) работает на фреймворке

You must be registered for see links

,

You must be registered for see links

. Метод применяется не сам по себе, а как улучшение уже существующих остаточных нейросетей (residual neural networks, ResNet). Основная концепция в том, чтобы поток градиента распространялся по разным сетевым путям через разделения потока градиента. Таким образом распространяемая информация о градиенте может иметь большую корреляцию, если переключать этапы конкатенации и перехода. CSPNet может значительно сократить объем вычислений, повысить скорость вывода и точность. Как видно из картинки выше, суть CSPNet заключается в более сложной обработке

You must be registered for see links

(feature pyramid network,

You must be registered for see links

).-

You must be registered for see links«CSPNet: A New Backbone that can Enhance Learning Capability of CNN»

-

You must be registered for see links,You must be registered for see links

Рисунок — Пример пирамиды признаков

DenseNet

Рисунок — Один плотный блок DenseNet c 5 слоями и скоростью роста k = 4. Каждый слой принимает все предыдущие карты признаков в качестве входных данных.

Рисунок — DenseNet с тремя плотными блоками

DenseNet (Densely Connected Convolutional Network) была предложена в 2017 году. Успех ResNet (Deep Residual Network) позволил предположить, что укороченное соединение в CNN позволяет обучать более глубокие и точные модели. Авторы проанализировали это наблюдение и представили компактно соединенный (dense) блок, который соединяет каждый слой с каждым другим слоем. Важно отметить, что, в отличие от ResNet, признаки («фичи») прежде чем они будут переданы в следующий слой не суммируются, а конкатенируются (объединяются, channel-wise concatenation) в единый тензор. При этом количество параметров сети DenseNet намного меньше, чем у сетей с такой же точностью работы. Авторы

You must be registered for see links

, что DenseNet работает особенно хорошо на малых наборах данных.-

You must be registered for see links«Densely Connected Convolutional Networks»

-

You must be registered for see links

-

You must be registered for see linksна Keras +You must be registered for see linksэтой и многих других моделей в CoLab

-

You must be registered for see linksна Torch от автора, обученные модели иYou must be registered for see linksна других фреймворках

SAUNet

SAUNet (Shape Attentive U-Net) показывает наилучшие на начало 2020 года результаты по сегментации изображений МРТ сердца и предлагается автомами, как сеть по сегментации медицинских изображений.

Рисунок — SAUNet состоит из двух частей: одна часть обрабатывает текстуры (texture stream); вторая часть обрабатывает формы (gated shape stream). В кодировщике текстур сети U-Net используются блоки DenseNet-121 (смотрите выше

You must be registered for see links

), а в декодере в качестве слоев сети U-Net применяются «блоки внимания» (dual attention decoder block).Архитектура SAUNet является модульной и состоит из многих различных блоков:

You must be registered for see links

,

You must be registered for see links

,

You must be registered for see links

и механизма внимания на основе

You must be registered for see links

.-

You must be registered for see links«SAUNet: Shape Attentive U-Net for Interpretable Medical Image Segmentation»

-

You must be registered for see linksна PyTorch

DetNASNet

Рисунок — Архитектура DetNASNet

Многие детекторы объектов работают на сетях, которые спроектированы для классификации изображений, что не оптимально, потому что определение объектов (object detection) и классификация изображений (image classification) являются различными задачами. DetNASNet использует подход под названием Neural Architecture Search (

You must be registered for see links

) для разработки архитектур, которые определяют объекты. Авторы утверждают, что они впервые применили процесс NAS, т.е. автоматический поиск оптимальных гиперпараметров нейросети, для оптимизации задачи определения объектов. Количесто вычислений составило 44 GPU-дня на наборе данных COCO. Достигнутая точность лучше, чем у ResNet-101, с гораздо меньшим количеством FLOP-пов.-

You must be registered for see links«DetNAS: Backbone Search for Object Detection»

-

You must be registered for see linksна PyTorch

SM-NAS

Рисунок — Сравнение времени вывода (мс) и точности обнаружения (mAP) на наборе данных COCO.

В SM-NAS предлагается двухэтапная стратегия грубого поиска под названием Structural-to-Modular NAS (SM-NAS): первый этап поиска на структурном уровне направлен на поиск эффективной комбинации различных модулей; второй этап поиска на модульном уровне развивает каждый конкретный модуль и продвигает

You must be registered for see links

вперед к более быстрой сети для конкретных задач.- Исходный код не найден.

-

You must be registered for see links«SM-NAS: Structural-to-Modular Neural Architecture Search for Object Detection»

AmoebaNet

Рисунок — Архитектура сети AmoebaNet-A. Слева общая модель. В центре блок «Normal Cell». Справа блок «Reduction Cell».

AmoebaNet также относится к алгоритмам по автоматическому созданию нейросетей. AmoebaNet использует

You must be registered for see links

вместо алгоритмов обучения с подкреплением для автоматического поиска оптимальных архитектур нейросетей. AmoebaNet использует то же простарство поиска (search space), что и

You must be registered for see links

. Является очень затратной по вычислениям и использует сотни TPU (Tensor Processing Units) для вычислений.-

You must be registered for see links«Regularized Evolution for Image Classifier Architecture Search»

-

You must be registered for see links

Graph Neural Network

Graph Neural Network или нейронная сеть на графе, где искусственные нейроны — это узлы графа, а соединения между нейронами — это ребра графа. Полезны для решения задач машинного обучения на графах, т.е. если задачу можно представить в виде какого-нибудь графа. А на графах можно сделать очень многое и даже прововодить обработку изображений. Наиболее популярные библиотеки для машинного обучения на графах:

You must be registered for see links

для PyTorch,

You must be registered for see links

для TensorFlow,

You must be registered for see links

самая удобная для начала ознакомления.-

You must be registered for see linksв CoLab

-

You must be registered for see linksby Siraj Raval

-

You must be registered for see linksбиблиотеки DGL (Deep Graph Library)

Growing Neural Cellular Automata

Рисунок — Один шаг обновления модели

Growing Neural Cellular Automata являются скрещением идей клеточных автоматов и искусственных нейронных сетей, результатом которого являются «живые» самовоспроизводящиеся и взаимодействующие друг с другом изображения. Ничто не мешает вместо изображений взять любые другие объекты (текст, музыку и т.д.). Растущие нейронные клеточные автоматы выглядят привлекательно и эффектно. Изображения «выращиваются» из вектора в 16 чисел с плавающей запятой. Таким образом данные могут быть «упаковываны» в компактную цепочку чисел, как код ДНК, что в будущем может составить конкуренцию форматам сжатия данных типа JPEG (изображения), MP3 (звук), MPEG (видео) и ZIP (текст).

В

You must be registered for see links

исследователи объясняют принцип устройства растущих нейронных клеточных автоматов, а также пути достижения устойчивости картинки с течением времени, способность восстанавливаться (регенерировать) при повреждениях и устойчивость к вращению.-

You must be registered for see linksна сайте Distill

-

You must be registered for see linksв Colab notebook

-

You must be registered for see linksby Yannic Kilcher

- игра

You must be registered for see links

Импульсная нейронная сеть

Импульсная нейронная сеть или Spiking neural network является самой реалистичной с точки зрения физиологии. В ней нейроны обмениваются короткими импульсами одинаковой амплитуды. Первая научная модель импульсной нейросети была предложена еще в 1952 году Аланом Ходжкином и Эндрю Хаксли, однако данный вид искусственных нейронных сетей известен немногим специалистам в этой области. Основная идея состоит в том, чтобы скопировать поведение биологическкого нейрона. Такие модели могут быть полезны при изучении функций мозга. Для того, чтобы быстро летать, необязательно махать крыльями, однако при решении прикладных задач некоторые свойства можно позаимствовать у биологических организмов.

- Википедия (

You must be registered for see links,You must be registered for see links)

-

You must be registered for see linksна сайте PapersWithCode.com

DPM

DPM, Deformable Part Model detector, не нейросеть. Использует

You must be registered for see links

(смотрите

You must be registered for see links

) и гистограммы направленных градиентов (

You must be registered for see links

). Была популярна при обнаружении пешеходов где-то в 2009 году, а затем, как пишут в

You must be registered for see links

«Object Detection in 20 Years: A Survey», уступила первенство алгоритму Integral Channel Features (

You must be registered for see links

), который затем уступил первенство нейросетям.Сотни готовых «классических» алгоритмов могут использоваться для предварительной обработки и постобработки данных, как дополнение к нейросетям, которое обеспечивает новый синтез идей, и даже вместо нейросетей. Например, в

You must be registered for see links

«Deformable Part Models are Convolutional Neural Networks» алгоритм DPM заменяется на эквивалентную ему сверточную нейронную сеть.-

You must be registered for see links«Deformable Part Models are Convolutional Neural Networks» + довольно устаревшаяYou must be registered for see linksна MatLab и Caffe

Выводы

Усилия исследователей направлены на:

- автоматический поиск оптимальных параметров нейросети, развитие идей AutoML, «нейросеть генерирует нейросеть», Neural Architecture Search (

You must be registered for see linksиYou must be registered for see links);

- механизм внимания (attention mechanism), карты внимания;

- развитие сверточных сетей типа «песочные часы» для задач обнаружения объектов, которые часто используются как основные (backbone) модели в модульных архитектурах;

- модульность, многие современные state-of-the-art (SOTA) архитектуры сотоят из многих частей.

- автоматический поиск оптимальных параметров нейросети, развитие идей AutoML, «нейросеть генерирует нейросеть», Neural Architecture Search (

Чтение статей без последующей работы с исходным кодом дает мало пользы. Даже если понятна задумка исследователей, но без понятного исходного кода и умения использовать исходный код на практике такое знание не имеет смысла. Кроме осведомленности, что такой метод уже есть, чтобы не изобретать велосипед заново. После чтения «по диагонали» нескольких десятков статей в очередной раз убедился, что ИТ — это практическая дисциплина, нацеленная на результат.

P.S. Рекомендую видео блог

You must be registered for see links

, в котором автор объясняет и делает нейросети на Keras. Его

You must be registered for see links

— это как раз то, что нужно начинающему «нейрокодеру» вроде меня.Спасибо за внимание!